به گزارش صراط به نقل از ایران یکی از این روشها، تولید فایلهای صوتی جعلی باورپذیر است؛ یعنی ممکن است در یک صدای آشنا، دروغی بزرگ پنهان شده باشد؛ موضوعی که میتواند منجر به کلاهبرداری از کاربران شود. در همین رابطه، عرصه سیاسی فضایی است که هوش مصنوعی این پتانسیل را دارد که با تأثیرگذاری در مقاطع متفاوت و ازجمله انتخابات، خدشهدار کردن یک چهره سیاسی و... آینده یک کشور را تغییر دهد.

تغییر مسیر انتخابات با هوش مصنوعی

استفاده از صداهای جعلی سیاستمداران، زنگ خطر را در جهان به صدا درآورده تا جایی که «ورا یورووا»، معاون کمیسیون اتحادیه اروپا، دیپفیکهای سیاسی تولید شده با هوش مصنوعی را «بمب اتمی» توصیف کرد که میتواند مسیر تصمیمات رأیدهندگان را تغییر دهد و حتی به افزایش شکاف در جامعه و عمیقتر شدن اختلافات دامن بزند.

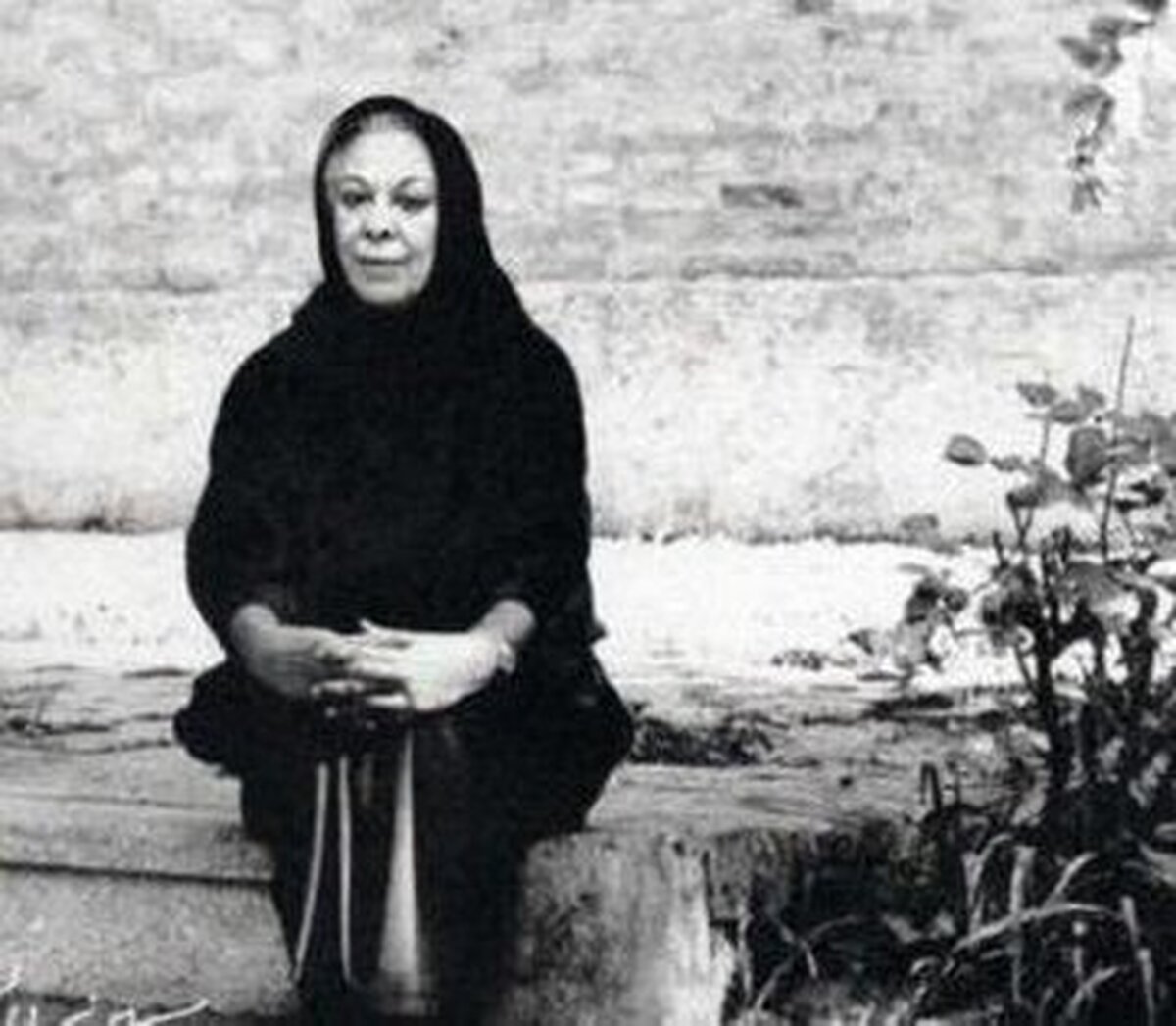

این موضوع وقتی نگرانکنندهتر شد که روزنامه واشنگتنپست در یک خبر اختصاصی گزارش داد، فردی ناشناس با کمک نرمافزارهای هوش مصنوعی اقدام به جعل هویت «مارکو روبیو»، وزیر خارجه آمریکا کرده و با تقلید صدا و سبک نوشتاری وی، یکسری پیامهای صوتی باورپذیر برای چند مقام ارشد داخلی و خارجی ارسال کرده است، اما این اولینبار نیست که چنین اتفاقی میافتد. مدتی پیش یک فایل صوتی از رهبر حزب کارگر بریتانیا در پلتفرم ایکس (توئیتر سابق) منتشر شد که در حال ناسزاگویی و تحقیر یکی از کارکنانش بود و در انتخابات سال گذشته اسلواکی هم یک فایل صوتی جعلی، منجر به بروز مشکلاتی در برگزاری انتخابات این کشور شد. هرچند بررسی نهادهای راستیآزمایی نشان داد این صداها حاوی نشانههایی از تولید یا دستکاری شدن توسط نرمافزارهای هوش مصنوعی هستند، ولی با این حال این محتواها همچنان در پلتفرمهایی مانند فیسبوک و ایکس باقی ماندند و دردسرساز شدند.

جولان صداهای جعلی در شبکههای اجتماعی

از آنجا که گاه حتی راستیآزماییهای انسانی هم در تشخیص جعلی بودن صداها با دشواری مواجهند، بیشک پلتفرمهای شبکه اجتماعی نیز در مدیریت محتوای صوتی تولید شده با هوش مصنوعی مشکلاتی دارند. علاوه بر این، تعداد کمی از شرکتهای نرمافزاری، ابزارهای حفاظتی برای جلوگیری از سوءاستفاده از صدا دارند.متخلفان و سودجویان، از صدای برخی هنرپیشهها هم برای کلاهبرداری بر بستر شبکههای اجتماعی مختلف از جمله تیکتاک استفاده کردند. یکی از آنها «تام هنکس»، بازیگر سرشناس است که از صدای وی برای تبلیغات دندانپزشکی استفاده شده بود. گاهی هم از راویان هوش مصنوعی برای تهیه یک گزارش خبری جعلی استفاده میشود. مؤسسه NewsGuard در ماه سپتامبر، 17 حساب کاربری را در تیکتاک شناسایی کرد که با استفاده از نرمافزارهای تبدیل متن به گفتار هوش مصنوعی، ویدیوهایی حاوی اطلاعات نادرست تولید و بیش از ۳۳۶ میلیون بازدید و ۱۴.۵ میلیون لایک جمعآوری کرده بودند. در یکی از این ویدیوها، ادعا شده است باراک اوباما در مرگ آشپز شخصیاش، «تافاری کمپبل»، دست دارد. گزارش خبری دیگری که با صدای هوش مصنوعی تولید شده، مدعی است «جیمی فاکس» بازیگر به دلیل تزریق واکسن کرونا فلج و نابینا شده است. این خبر طرفداران این بازیگر را بسیار نگران کرد ولی در نهایت برچسب جعلی خورد و پس از هشدار به تیکتاک، این پلتفرم برخی از این ویدیوها را حذف کرد.

تصویب یک قانون فوری

افزایش میزان صداهای جعلی به کار رفته در ویدیوها، سرانجام سبب شد گروهی از سناتورهای دموکرات و جمهوریخواه آمریکا پیشنویس لایحهای موسوم به «قانون ممنوعیت جعل» (No Fakes Act) را تصویب کنند. طبق این قانون، تولید یا توزیع نسخهای شبیهسازی شده از صدای فرد یا تصویر ویدیویی با استفاده از هوش مصنوعی بدون رضایت شخص، جرمانگاری میشود.

«هانی فرید»، استاد جرمشناسی دیجیتال از دانشگاه کالیفرنیا در اینباره میگوید:«فناوری شبیهسازی صدا از سال گذشته به سرعت پیشرفت کرده است و فراگیر شدن ابزارهای ارزان و در دسترس آنلاین باعث شده تقریباً هر کسی بتواند یک خبر صوتی جعلی و پیچیده تولید کند. این استاد دانشگاه با اشاره به اینکه فایلهای صوتی دروغین، پیامدهای جدی برای افراد، جوامع و دموکراسی دارد، میافزاید:«صدای سیاستمداران و افراد سرشناس، ابزار کار آنهاست که هوش مصنوعی عملاً از این ابزار، علیه خودشان استفاده میکند. در گذشته، نرمافزارهای شبیهساز صدا، خروجیهای غیرواقعی تولید میکردند اما با افزایش قدرت پردازش هوش مصنوعی، این فناوری اکنون میتواند میلیونها نمونه صوتی را تحلیل و با شناسایی الگوهای بنیادین گفتار، ظرف چند ثانیه صدای دلخواه را عیناً بازتولید کند. ابزارهای آنلاین مانند سرویس شرکت Eleven Labs به کاربران اجازه میدهد با اشتراک ماهانه 5 دلار و تنها با در اختیار داشتن چند ثانیه از صدای فرد مورد نظر، متن دلخواه خود را وارد کرده و یک صدای جعلی مشابه تولید کنند.»